2024.11.07

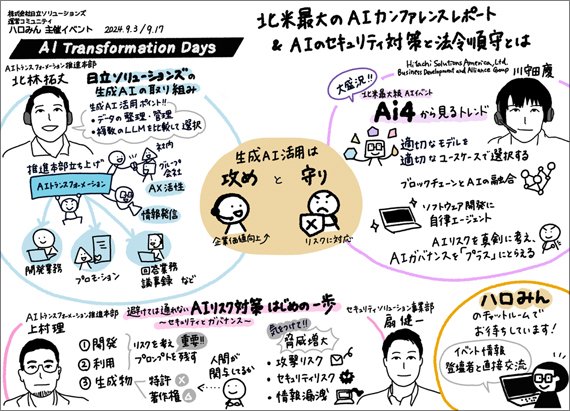

日立ソリューションズが運営するコミュニティ「ハロみん」は、2024年9月3日・9月17日に「AI Transformation Days:北米最大級のAIカンファレンスレポート&AIのセキュリティ対策と法令遵守(著作権対応・欧州AI規制法等)とは?!」を開催しました。

このイベントでは、実際にAIを事業活動や企業活動で活用していく方に向けて、ラスベガスで2024年8月に開催されたAIに関するカンファレンス「Ai4」から得られたトレンド情報や、AI活用の取り組み事例・リスクをライブ配信でお届けしました。

今回のイベントレポートでは、セミナー中に紹介された生成AIのトレンドと、ガバナンスやセキュリティ対策について、また、日立ソリューションズでの生成AI活用の取り組みをご紹介します。

北林 拓丈

株式会社日立ソリューションズ

AIトランスフォーメーション推進本部

川守田 慶

Hitachi Solutions America, Ltd.

Business Development and Alliance Group

扇 健一

株式会社日立ソリューションズ

セキュリティソリューション事業部

上村 理

株式会社日立ソリューションズ

AIトランスフォーメーション推進本部

「Ai4 2024」は北米最大級のAIイベントで、企業やベンダーに依存しない組織「Fora Group」が主催。350人以上の講演者によるセッションやパネルディスカッションなどが繰り広げられ、75以上の国と地域から約5,000人が参加しました。

※写真は主催者より提供

その中のキーノートでは、生成AIのトレンドについて紹介されました。具体的には以下の3つの注目度が高まっているとのことです。

各トレンドをテーマに実施されたキーノートやセッションの内容を一部抜粋して紹介します。

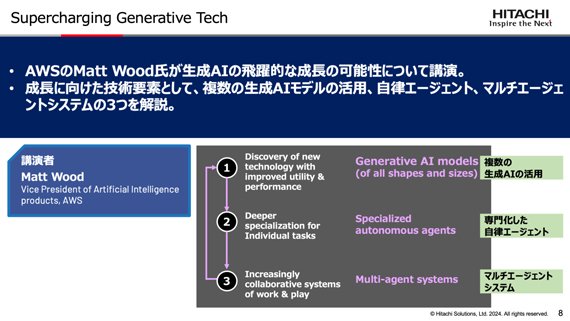

AWSのMatt Wood氏による、生成AIの飛躍的な成長の可能性についての講演内容を、川守田から紹介しました。

講演では、成長に向けた技術要素として、複数の生成AIモデルの活用、自律エージェント、マルチエージェントシステムの3つが取り上げられました。

新しい生成AIモデルが様々な形やサイズで登場している中、各モデルでは得意とするユースケースや運用上の特性が異なるため、1つのモデルで網羅できないのが現状です。そのため、適切なモデルを適切なユースケースで選択することが重要とされています。

そんな中、特殊なモデルを使用して計画を分割して目標を実行する「自律エージェント」にも注目が集まっています。例えば、「指定したアウトラインを科学的研究調で2,000字以内の初稿に展開する」という目的の場合、計画は「文章を箇条書きから段落に拡張する」「出典の引用を列挙する」「スペルと文法を評価する」「文体を見直して編集する」といった4つに分割して実行できるというものです。

自律エージェントはソフトウェア開発への活用も期待されています。セッションの中では、コードやテストなどを生成するアシスタント「Amazon Q」を例に、将来的には自律エージェントが代わりにタイピングしてくれるようになるとの予測があると紹介がありました。

今後は、モデルを特化し、自律エージェントを活用して組み合わせることで、生成AIの飛躍的成長に近づいていけるのではないかと言及されていました。

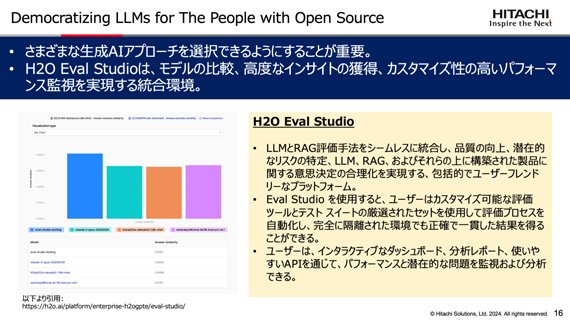

続いて、H2O.aiのSri Ambati氏の講演では、同社が提供する生成AI機能である「Danube」と「H2O Eval Studio」を事例として、小規模言語モデル(SLM)の活用について語られました。

「Danube」は小規模言語モデルで、PCやIoTセンサー、デスクトップ、タブレットなどのデバイス、オフラインのアプリケーション上で利用できるものです。精度がMicrosoftに匹敵する高性能なモデルであることに加え、経済的にも効率的で、エッジデバイスにも簡単に展開できます。

「H2O Eval Studio」は、LLMとRAG評価手法をシームレスに統合し、意思決定の合理化を実現するプラットフォーム。これにより、ユーザーはカスタマイズ可能な評価ツールとテスト スイートの厳選されたセットを使用して、評価プロセスを自動化し、完全に隔離された環境でも正確で一貫した結果を得られます。

こうした事例を通して、様々な生成AIアプローチを選択できるようにすることが重要、と強調されていました。

また、生成AIを活用する上では「データの整理・管理」「複数のLLMを比較・評価して最も適しているものを選択する」が重要であると、北林がキーノートを通しての所感を述べました。

AIガバナンスについては、AIの規制やリスクなどに対してどのように対応していくべきか、研究者やエンジニアなど様々な立場で議論が活発に行われました。

その中で、AIガバナンスを、規制やリスクへの対応といった「守り」の領域としてとらえるだけではなく、戦略的アドバンテージや創造性を向上させるための「攻め」の領域としてとらえることが重要、という主張が複数見られました。

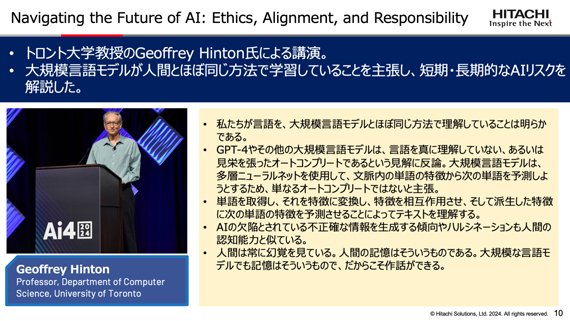

トロント大学教授のGeoffrey Hinton氏は、大規模言語モデルが人間とほぼ同じ方法で学習しており、短期・長期的なAIリスクがあると解説。

短期的なAIリスクとしては、フェイク画像・声・ビデオ、大規模な雇用喪失(知的労働)、致死性の自律兵器、サイバー犯罪と意図的なパンデミック、差別と偏見が挙げられています。実際にフィッシング攻撃は昨年に比べ大幅に増加しており、大規模なAIモデルの重みが公開されれば、サイバー犯罪やウイルス設計のための微調整が容易になるため、非常に危険です。一方で、AIはヘルスケアなどの分野で大いに役立つからこそ、AIの発展を止めることはできないと述べられました。

また、長期的なリスクとしては、AIは異なるコピー間で知識を共有する能力が高いことから、長期的にはより優れた知能形態になる可能性があります。そのため、AIが人間より賢くなって人間による制御を失う可能性がリスクとして挙げられ、制御方法について真剣に考える必要がある、と主張されました。

※写真は主催者より提供

その他のセッションでも、データに関するガバナンスにも言及され、データが連携されていない「サイロ化」を防ぐことが重要であるとの解説がありました。また、従来のシステムリスク管理と同様に、AIモデルの管理とリスク評価・管理を行い、第三者によるチェックを行うことの重要性が、北林によって説明されました。

生成AIの進化が政治や経済・雇用へも影響を及ぼしていることの例として、Andrew Yang氏が発表した「生成AIと政治」についてのセッションが取り上げられました。

生成AIの進化によってホワイトカラーの仕事に大きな影響を与えており、また、政治的な議論が活発化。コールセンターの従業員や事務職、小売業、飲食業などに影響があり、労働市場の構造が大きく変わる可能性があります。また、AIが生み出す経済的価値がどのように一般市民に分配されるのか、AI使用に税金をかける仕組みをどうするか、といった影響が出ています。

政策への提言として、ユニバーサルベーシックインカム(UBI)で、AIによる雇用喪失に対して経済的な安定を図ることや、AI税収を子どもの貧困対策に回して将来的な社会コスト削減を期待することなどが挙げられていました。

また、米大統領選においてディープフェイクや偽情報が出回ることが懸念されており、大統領選の直近2週間はSNSのフィード・通知をオフにしたほうがいいと言及されました。

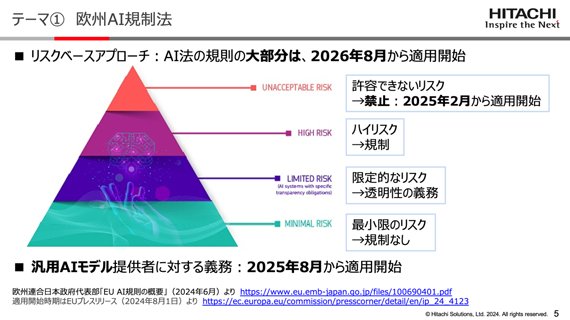

上村が、国際的にAI規制が目まぐるしく進展する中での典型的なルールとして、欧州のAI規制法について解説しました。

欧州AI規制法では、人々の基本的権利に対する明らかな脅威と見なされるAIシステムは、許容できないリスクとして禁止されます。具体的には、サブリミナル技術を使用するAIシステム、政府や企業によるソーシャルスコアリング、顔画像データベースなどが挙げられます。AI法の規則の大部分が2026年8月適用開始であるのに対して、これらは2025年2月に適用開始です。

また、著作権関連について、具体事例をいくつか挙げて解説されました。

比較として特許の事例を取り上げ、「発明者は人間に限られる」として、AIが発明した特許が認められていない事例についても解説されました。

著作権については、AI生成物を生み出す過程において、利用者に創作意図があり創作的寄与があれば、著作者は利用者となる一方で、創作的寄与が認められないような簡単な指示にとどまる場合は著作物と認められないとされています。

さらに、文化庁が公開した「AI著作権チェックリスト&ガイダンス」では、既存の著作物と類似していないかの確認とともに、依存性がないことを説明できるよう、生成に用いたプロンプトなど、生成物の生成過程を確認可能な状態にしておくことが望まれると記載されています。

情報処理推進機構(IPA)が公開している『情報セキュリティ10大脅威 2024[組織]』の中で、生成AIによって攻撃が激化する可能性があるものが6つ該当する、と扇から発表されました。

これらの脅威は、例えば、メール作成・ボイスメッセージ作成などのソーシャルエンジニアリング、CAPTCHA認証突破、マルウェア開発、システムやセキュリティ対策製品の弱点の収集と攻撃シナリオの作成などにおいて、生成AIが利用されることでリスクが増大し脅威が激化すると考えられています。

また、生成AIシステムのセキュリティリスクにおいては、AIモデルを騙すための悪意のあるプロンプトが入力される敵対的攻撃や、企業内にて学習させたAIモデルや学習データの窃取や破壊、誤った情報を与え学習させるデータポイズニング、クラウド生成AIへの情報漏洩などがあります。

このように、生成AIを活用した不審メールなどにより、サイバー攻撃がますます巧妙になっており、業務・プライベートにかかわらず、これまで以上に注意を払うことが必要です。また、生成AIを活用したシステムを構築する際は、セキュリティリスクを考慮し対策も含めて検討する必要がある、と締めくくられました。

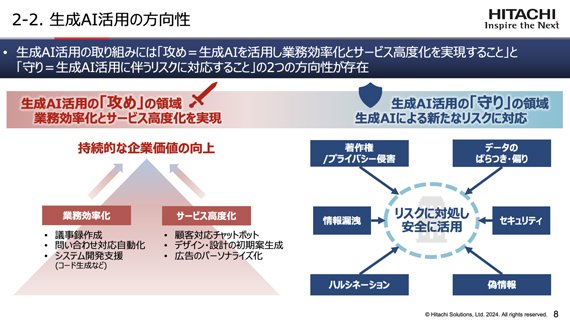

日立ソリューションズでの生成AI活用の取り組みの方向性は、生成AIを活用して業務効率化とサービス高度化を実現する「攻め」と、生成AI活用に伴うリスクに対応する「守り」の2つです。

「攻め」においては、持続的な企業価値の向上に向けて、議事録作成や問い合わせ対応自動化、システム開発支援などで業務効率化に繋げたり、顧客対応チャットボットやデザイン・設計の初期案生成、広告のパーソナライズ化などでサービス高度化を推進したりしています。

「守り」においては、著作権・プライバシー侵害、情報漏洩、データのばらつき・偏り、セキュリティ、偽情報、ハルシネーションのリスクに対処して、安全に生成AIを活用する取り組みを進めています。

2023年は生成AIに価値があるかどうかを実際に触って理解する試用期間でしたが、2024年からは本格活用を始動させています。

社内体制としては、業務革新統括本部内に「AIトランスフォーメーション推進本部」を立ち上げ、その中で「AX戦略部」「AX生産技術部」「AIリスク管理センタ」の3つの部門が、AX(AI トランスフォーメーション)戦略の策定や推進、浸透、健全な運営を行う他、社内外を問わず連携に取り組んでいます。

AIトランスフォーメーション推進における重点施策は以下の通りです。

●社内およびグループ会社内におけるAXの強力な活性化

●AI関連でのプレゼンスの向上

●市場環境・技術動向を踏まえた戦略策定と変化への追従

具体的な取り組み事例には、開発業務にGitHub Copilotを活用したり、プロモーション業務におけるタイトルなどのアイデア出しなどに生成AIを活用したりして、業務効率化を図っています。

日立ソリューションズの生成AIソリューションとして、「攻め」の領域では、OA業務支援や個別業務支援、開発業務支援の他、伴走型の導入支援サービスなどによる環境提供、「守り」の領域ではリスク対応を行うプロダクトのラインナップを増やしていきます。

本イベントレポートが、生成AIのトレンド把握と、ガバナンスやセキュリティ対策においてお役に立てれば幸いです。